Creen que cuando funcione van a a tener 10 petabytes o sea 10 millones de gigabytes de datos por año para analizar, (llenarían más 2 millones de DVDs). Un una pila de CDs de 20 km de alto ...

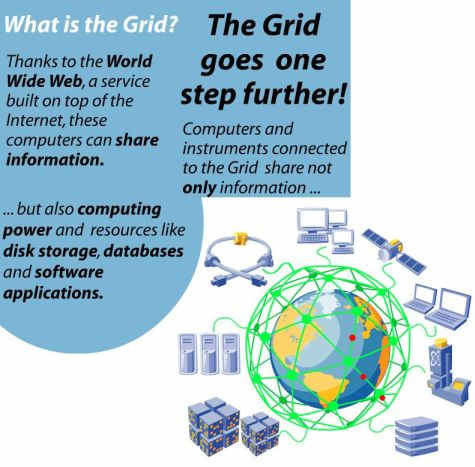

Para lidiar con esto han organizado un sistema de computación distribuida, (grid computing en inglés), que a repartirse por varios lugares del globo para almacenar y procesar los datos.

Hay quienes describen a esta red de computadoras como "la evolución de internet".

Está compuesta de 3 niveles, el Nivel Cero es centro de cómputos del CERN a donde llegarán los datos desde los detectores de partículas.

Este grupo de 340 servidores Xeon 5160 con 1360 núcleos en el año 2007 llegó a ser la supercomputadora nº 115 en el listado de las Top 500, hoy creo que está 96 pues parece que lo ampliaron. Es lo que es el nivel 0. Acá abajo una foto tomada de isgtw.org.

De cada detector hay un enlace de fibra optica de 10 Gigabits por segundo que lleva al centro de computos , el Nivel 0. Allí tendrían unos 27 terabytes de datos "crudos", por día que guardarían primero en discos y luego en cinta. ( 27 terabytes son unos 27 mil gigabytes).

Allí en granjas de computadoras harán un filtrado para obtener unos 10 terabytes de datos por día, los llaman ESD

Los datos "Crudos" y "procesados" se van a enviar a 11 centros de Nivel 1, que están en Europa, EEUU y Asia.

A los que el CERN está conectado con enlaces de 10 Gbits por segundo.

( 10 Gb/s son 10 mil veces más que 1 Mb/s, una conexión a internet normal de hoy en día. La red local que nos armamos en lo de Pop andaba en teoría a 100 Mb/s, los científicos que accedan a la red LCG tienen 100 veces más velocidad que nosotros en esa LAN) .

En cada centro Nivel 1, van a guardar los datos crudos en cinta y van a redistribuir los datos parcialmente procesados ESD a los centros Nivel 2. Allí obtendrán un nuevo nivel de proceso para tener información ESD2 y van a almacenar y redistribuir estos datos.

Va a haber 150 centros de Nivel 2 distribuidos por todo el mundo. Son principalmente universidades. Allí se van a hacer simulaciones y se van a enviar los datos a los centros de Nivel 1 para almacenarlos.

Estiman que unos 7 mil físicos manipularán los datos.

Hay una muy clara descripción gráfica y animada del funcionamiento de la red en gridcafe.web.cern.ch.

La red mundial distribuida del LHC constará de más de 20 mil servidores que corren principalmente sobre Linux.

En esta red la discografía de los Rollings Stones podría mandarse entera en sólo 2 segundos.

Y la desarrollaron una red de cómputo distribuída pues necesitan tanto poder de cálculo que si tuvieran todo concentrado en el CERN tendrían problemas para alimentar electricamente las computadoras ....

La cantidad de datos a analizar va a ser tal que esperan que la red LCG trabaje en ellos durante años.

Es poco probable que los usuarios comunes accedamos a esta super-red pero las tecnologías que están empleando ya están siendo miradas por las empresas de telecomunicaciones.

Fuente : la nota, Parallel Internet: Inside the Worldwide LHC computing Grid en techworld.com y el artículo Coming soon: superfast internet.

Los temas vinculados a redes de alta velocidad de computación distribuida no son menores, implican el desarrollo de nuevos protocolos, (hay uno llamado GridFTP), la administración de los recursos; la autenticación de los usuarios, la protección contra fallas, el desarrollo del middleware, (ese software que va entre el sistema operativo y las aplicaciones y administra los recursos de la red distribuida).

La red LCG tiene su sitio web por acá.

Hay explicaciones bien claras sobre los beneficios de la computación distribuida, qué es , cómo trabaja, . Me enteré gracias a este sitio.

Si las cifras involucradas no les mueven un pelo, todavía tengo unos números más para mostrarles...

Continuará...